Googleゴーグル vs CamFind

先日、Google NowがiOSにも対応しましたね。

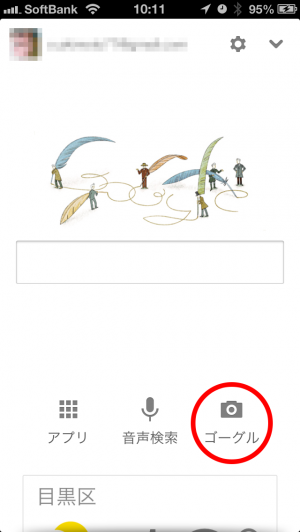

既にご存知の方も大勢いると思いますが、iPhoneアプリとしての「Google検索」のトップには「Googleゴーグル」の機能があります。ここでは「ゴーグル」とだけ表示されています。

先日の記事でも書きましたが、結論としては「CamFind」の方が認識精度が高い。です。

ただし、私の記憶にある「Googleゴーグル」の以前の性能だけで比較するのは比較としては不十分で不公平ということで、改めて現在の性能にて検証してみました。

Googleゴーグルの使い方(独立アプリの方ではないですよ)

iPhoneアプリの「Google 検索」をタップして起動します。

Google検索のトップが表示されるので、続けて右下の「ゴーグル」をタップ。

▼こちらがその画面です。

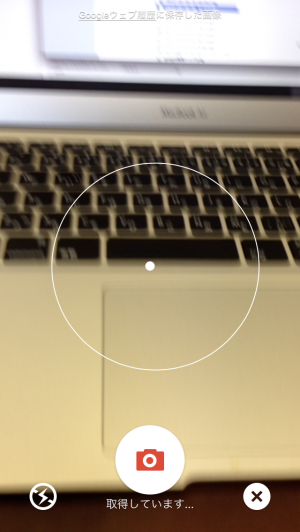

この状態で画像検索したい対象物を画面中央の●のところに合わせます。イメージとしては「戦闘機のロックオン」のような感じです。

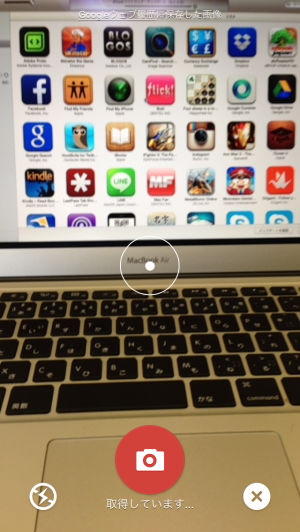

先ほどの画像と見比べて頂くと、中央の●の周りの円が小さくなっているのが分かります。更に、カメラのボタンが赤白反転しているのが分かると思います。

これが「ロックオン完了」=「情報取得出来たよ」という状態です。

逆に言うとこの状態にならないものは「Googleには分かりません」ということなのです。

カメラボタンが赤白反転したら、このボタンをタップします。

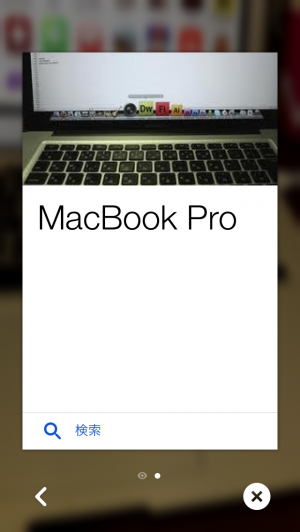

あ、惜しい。これは「MacBook Air」が正解だったのですが…

▼ちなみにこの後何かの拍子にこの結果が

こちらも惜しい、実はこれは13インチが正解なのです。

この結果を見て気付いたことがあります。それは、Googleゴーグルの検索結果はその対象をみる「視点」によって変化するということです。

「MacBook Pro」と誤認識された際の画像の視点(カット)と、検索結果の視点は酷似しています。

そしてその後「MacBook Air 11」と認識された際には、iPhoneを移動していた際にちょうど検索結果の視点(カット)・同じ角度でMacBook Airをカメラの視界に捉えたタイミングでした。

なるほど、これは「やっぱりMacBook Airだね」と正解に近づいたのではなく、恐らくGoogleの保有する画像データベースにおいて、この視点から撮影された画像で類似しているものとしては「MacBook Airの11インチ」しかなかった?ため、そういう結果が導き出されたのではないかと思うのです。

先日のCamFindでは即座に「MacBook Air」という結果が返って来たことと比較すると、やはり精度というところではCamFindの方が上な感じがしますね〜

続けて身の回りの色々なものをカメラに捉えてみたのですが、なかなかロックオンませんね。まだ実用レベルではない感じです。

そこで発想を切り替えて「これなら分かるでしょ」というレベルのものでテスト。

▼その結果

さすがにちゃんと出ましたね。

最後のまとめ

精度というところではやはり今回の再テストでも「CamFind」の勝利でした。

ただし、1ついえることはどちらもまだまだ実用レベルとは言えないかのでおもしろアプリというレベルな気がします。

それから今回は再テストということでGoogle検索アプリにおける「ゴーグル」を改めて検証してみたのですが、私個人としてはGoogle検索の「ゴーグル」の方が動作としては快適で面白いと感じました。

- カメラで対象を補足

- ロックオン

- ミサイル発射(情報取得)

というゲーム感覚です。

またそれだけではなく、動作が快適という点においては

CamFindでは

- カメラで撮影

- サーバーに情報UP(自動ですが)

- 情報取得 → ○ or ×

- ×の場合はやり直し

というプロセスですが、一方のゴーグルではカメラ内で捉えて情報取得ができた時だけ「ボタンが赤白反転」というリアクションです。要するに「試しにやってみたけど失敗しました」というのが無いのです。その点CamFindは正直イラッとします。

これらを比較すると、私の中での結論は「Google ゴーグル」でいいかなになりました。どちらも実用レベルではないのであれば、わざわざ別アプリを入れなくてもよいという感覚もあります。

今後、なんだか分からないけどカメラを通すとその情報が取得出来るという技術は各方面で活躍出来ると思いますので、ユーザーとしては是非とも切磋琢磨して技術が上がることを期待したいですね。